هوش مصنوعی مسئول (مسئولیت پذیر) یا Responsible AI رویکردی برای توسعه و به کارگیری هوش مصنوعی (AI) از نظر اخلاقی و قانونی است. هدف هوش مصنوعی مسئول به کارگیری هوش مصنوعی به شیوه ای ایمن، قابل اعتماد و اخلاقی است. استفاده مسئولانه از هوش مصنوعی باید شفافیت را افزایش دهد و به کاهش مسائلی مانند سوگیری هوش مصنوعی کمک کند.

بر اساس تعریف مجمع جهانی اقتصاد، “هوش مصنوعی مسئول تمرین طراحی، ساخت و استقرار هوش مصنوعی به شیوه ای است که افراد و مشاغل را توانمند می کند و بر مشتریان و جامعه تاثیر می گذارد – به شرکت ها اجازه می دهد اعتماد ایجاد کنند و هوش مصنوعی را با اطمینان مقیاس کنند و رشد دهند.”

طرفداران هوش مصنوعی مسئولیت پذیر امیدوارند که چارچوب حاکمیتی به طور گسترده ای از بهترین شیوه های هوش مصنوعی به سازمان ها در سراسر جهان آسان تر می شود تا اطمینان حاصل کنند که برنامه نویسی هوش مصنوعی آنها انسان محور، قابل تفسیر و قابل توضیح است. وجود یک سیستم هوش مصنوعی مسئول، عدالت، قابلیت اطمینان و شفافیت را تضمین می کند.

با این حال، استانداردهای قابل اعتماد هوش مصنوعی در حال حاضر به صلاحدید دانشمندان داده و توسعه دهندگان نرم افزاری است که مدل های هوش مصنوعی یک سازمان را می نویسند و به کار می برند. این بدان معناست که اقدامات لازم برای جلوگیری از تبعیض و تضمین شفافیت از شرکتی به شرکت دیگر متفاوت است.

پیاده سازی نیز می تواند از شرکتی به شرکت دیگر متفاوت باشد. به عنوان مثال، افسر ارشد تجزیه و تحلیل یا سایر افسران و تیم های اختصاصی هوش مصنوعی ممکن است مسئول توسعه، پیاده سازی و نظارت بر چارچوب هوش مصنوعی مسئول سازمان باشند. توضیحی در مورد چارچوب سازمان باید در وب سایت سازمان مستند باشد، و فهرستی از نحوه رسیدگی به مسئولیت پذیری و اطمینان از ضد تبعیض آمیز بودن استفاده از هوش مصنوعی ارائه شود.

-

ابزار و گزارش آماده تدوین نقشه راه بکارگیری هوش مصنوعی مولد در سازمان

امتیاز 5.00 از 55.000.000 ریالقیمت اصلی 5.000.000 ریال بود.4.500.000 ریالقیمت فعلی 4.500.000 ریال است.

ضرورت و اهمیت هوش مصنوعی مسئول

هوش مصنوعی مسئول حوزه ای است که هنوز در حال ظهور است. استفاده از کلمه مسئول یک اصطلاح کلی است که هم اخلاق و هم دموکراسی را در بر می گیرد.

اغلب، مجموعه دادههایی که برای آموزش مدلهای یادگیری ماشین (ML) استفاده میشوند، سوگیری را به هوش مصنوعی وارد میکنند. این به دلیل داده های ناقص یا معیوب، یا به دلیل تعصبات کسانی است که مدل ML را آموزش می دهند. هنگامی که یک برنامه هوش مصنوعی مغرضانه باشد، می تواند تأثیر منفی بر انسان ها بگذارد یا به آنها آسیب برساند – مانند کاهش ناعادلانه درخواست ها برای وام های مالی یا، در مراقبت های بهداشتی، تشخیص نادرست حق ثبت اختراع.

اکنون که برنامههای نرمافزاری با ویژگیهای هوش مصنوعی رایجتر شدهاند، به طور فزایندهای آشکار میشود که نیاز به استانداردهایی در هوش مصنوعی فراتر از استانداردهایی وجود دارد که توسط نویسنده داستانهای علمی تخیلی آیزاک آسیموف در “سه قانون رباتیک” خود ایجاد کرده است.

اجرای هوش مصنوعی مسئول میتواند به کاهش تعصب هوش مصنوعی، ایجاد سیستمهای هوش مصنوعی شفافتر و افزایش اعتماد کاربران نهایی به این سیستمها کمک کند.

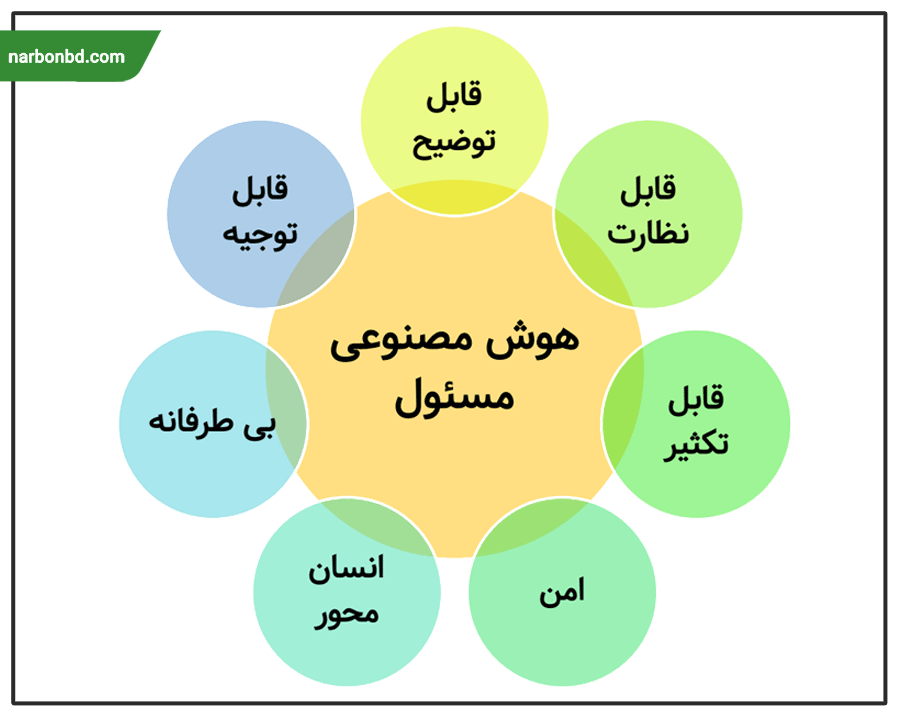

اصول هوش مصنوعی مسئول

مدلهای هوش مصنوعی و یادگیری ماشین باید از فهرستی از اصولی پیروی کنند که ممکن است از سازمانی به سازمان دیگر متفاوت باشد.

به عنوان مثال، مایکروسافت و گوگل هر دو از فهرست اصول خود پیروی می کنند و موسسه ملی استانداردها و فناوری (NIST) نسخه 1.0 چارچوب مدیریت ریسک هوش مصنوعی را منتشر کرده است که از بسیاری از اصول مشابه موجود در لیست های مایکروسافت و گوگل پیروی می کند. فهرست هفت اصل NIST شامل موارد زیر است:

- پاسخگو و شفاف. افزایش شفافیت به منظور ایجاد اعتماد بیشتر به سیستم هوش مصنوعی است و در عین حال رفع مشکلات مربوط به خروجی های مدل هوش مصنوعی را آسان تر می کند. این همچنین توسعه دهندگان را قادر می سازد تا مسئولیت بیشتری نسبت به سیستم های هوش مصنوعی خود داشته باشند.

- قابل توضیح و تفسیر. قابلیت توضیح و تفسیرپذیری به منظور ارائه بینش عمیق تر در مورد عملکرد و قابل اعتماد بودن یک سیستم هوش مصنوعی است. برای مثال، هوش مصنوعی قابل توضیح، به کاربران توضیح می دهد که چرا و چگونه به خروجی خود رسیده است.

- منصفانه با سوگیری مضر مدیریت شده است. منظور از انصاف رسیدگی به مسائل مربوط به تعصب و تبعیض هوش مصنوعی است. این اصل بر ارائه برابری و برابری تمرکز دارد، که دشوار است زیرا ارزش ها در هر سازمان و فرهنگ متفاوت است.

- حفظ حریم خصوصی. حریم خصوصی به معنای اعمال شیوه هایی است که به حفظ استقلال، هویت و منزلت کاربر نهایی کمک می کند. سیستم های هوش مصنوعی مسئول باید با ارزش هایی مانند ناشناس بودن، محرمانه بودن و کنترل توسعه یافته و به کار گرفته شوند.

- ایمن و مقاوم. سیستم های هوش مصنوعی مسئول باید در برابر تهدیدات احتمالی مانند حملات خصمانه ایمن و انعطاف پذیر باشند. سیستمهای هوش مصنوعی مسئول باید به گونهای ساخته شوند که از حملات اجتناب کنند، در برابر آن محافظت کنند و به آنها پاسخ دهند و در عین حال بتوانند پس از حمله بازیابی شوند.

- معتبر و قابل اعتماد. سیستمهای هوش مصنوعی مسئول باید بتوانند عملکرد خود را در شرایط مختلف غیرمنتظره بدون شکست حفظ کنند.

- بی خطر. هوش مصنوعی مسئول نباید جان انسان، دارایی یا محیط زیست را به خطر بیندازد.

طراحی هوش مصنوعی مسئول

بررسی مداوم برای اطمینان از اینکه سازمان متعهد به ارائه یک هوش مصنوعی بی طرفانه و قابل اعتماد است، بسیار مهم است. به همین دلیل است که برای یک سازمان بسیار مهم است که در هنگام طراحی و اجرای یک سیستم هوش مصنوعی از یک مدل بلوغ پیروی کند.

در سطح پایه، هوش مصنوعی مسئول باید حول استانداردهای توسعه ساخته شود که بر اصول طراحی هوش مصنوعی مسئولانه تمرکز دارند. از آنجایی که این اصول در هر سازمان متفاوت است، هر یک باید به دقت در نظر گرفته شوند. هوش مصنوعی باید با منابعی مطابق با استاندارد توسعه شرکتی ساخته شود که استفاده از موارد زیر را الزامی می کند:

- مخازن کد مشترک

- معماری مدل تایید شده

- متغیرهای تحریم شده

- روشهای تست سوگیری را برای کمک به تعیین اعتبار تستها برای سیستمهای هوش مصنوعی ایجاد کرد.

- استانداردهای پایداری برای مدلهای یادگیری ماشین فعال برای اطمینان از اینکه برنامهنویسی هوش مصنوعی همانطور که در نظر گرفته شده است کار میکند.

مدلهای هوش مصنوعی باید با اهداف مشخصی ساخته شوند که بر ساخت یک مدل به روشی ایمن، قابل اعتماد و اخلاقی تمرکز کنند. به عنوان مثال، یک سازمان می تواند هوش مصنوعی مسئول با اهداف و اصول ذکر شده در شکل زیر ایجاد کند.

پیادهسازی یا اجرای هوش مصنوعی مسئول

یک سازمان به روش های زیر می تواند هوش مصنوعی مسئول را پیاده سازی کند و نشان دهد که یک سیستم هوش مصنوعی مسئول ایجاد کرده است:

- اطمینان حاصل کنید که داده ها به گونه ای قابل توضیح هستند که انسان بتواند آن را تفسیر کند.

- طراحی سند و فرآیندهای تصمیمگیری تا جایی که اگر اشتباهی رخ دهد، میتوان آن را مهندسی معکوس کرد تا مشخص شود چه اتفاقی افتاده است.

- فرهنگ کاری متنوع ایجاد کنید و بحث های سازنده را برای کمک به کاهش تعصب ترویج دهید.

- از ویژگی های قابل تفسیر برای کمک به ایجاد داده های قابل درک برای انسان استفاده کنید.

- یک فرآیند توسعه دقیق ایجاد کنید که قابلیت مشاهده را در ویژگی های پنهان هر برنامه ارزش گذاری کند.

- بر حذف روش های توسعه مدل هوش مصنوعی جعبه سیاه معمولی تمرکز کنید. در عوض، روی ساخت جعبه سفید یا سیستم هوش مصنوعی قابل توضیح تمرکز کنید، که توضیحی برای هر تصمیمی که هوش مصنوعی میگیرد، ارائه میکند.

الگوهای بهینه از اصول هوش مصنوعی مسئول

هنگام طراحی هوش مصنوعی مسئول، فرآیندهای حاکمیتی باید سیستماتیک و قابل تکرار باشند. برخی از بهترین شیوه ها شامل موارد زیر است:

- بهترین شیوه های یادگیری ماشین را پیاده سازی کنید.

- فرهنگ حمایتی متنوعی ایجاد کنید. این شامل ایجاد تیمهای جنسیتی و نژادی است که روی ایجاد استانداردهای هوش مصنوعی مسئول کار میکنند. این فرهنگ را فعال کنید تا آزادانه در مورد مفاهیم اخلاقی در مورد هوش مصنوعی و تعصب صحبت کند.

- ترویج شفافیت برای ایجاد یک مدل هوش مصنوعی قابل توضیح به طوری که هر تصمیمی که توسط هوش مصنوعی گرفته می شود قابل مشاهده و به راحتی قابل تعمیر باشد.

- کار را تا حد امکان قابل اندازه گیری کنید. برخورد با مسئولیت امری ذهنی است، بنابراین اطمینان حاصل کنید که فرآیندهای قابل اندازه گیری مانند قابل مشاهده بودن و توضیح پذیری وجود دارد و چارچوب های فنی و چارچوب های اخلاقی قابل حسابرسی وجود دارد.

- از ابزارهای هوش مصنوعی مسئول برای بازرسی مدل های هوش مصنوعی استفاده کنید. گزینه هایی مانند جعبه ابزار TensorFlow در دسترس هستند.

- معیارهایی را برای آموزش و نظارت شناسایی کنید تا به حداقل رساندن خطاها، موارد مثبت کاذب و سوگیری ها کمک کنید.

- برای کمک به تولید نتایج قابل تأیید و افزایش اعتماد کاربر نهایی، آزمایش هایی مانند تست سوگیری یا نگهداری پیش بینی را انجام دهید.

- پس از استقرار به نظارت ادامه دهید. این کمک می کند تا اطمینان حاصل شود که مدل هوش مصنوعی به شیوه ای مسئولانه و بی طرفانه به عملکرد خود ادامه می دهد.

- مراقب باشید و از این فرآیند درس بگیرید. یک سازمان بیشتر در مورد هوش مصنوعی مسئول در پیاده سازی می آموزد – از شیوه های منصفانه گرفته تا مراجع فنی و مطالب پیرامون اخلاق فنی.

نتیجه گیری

در این مقاله، بحث پیرامون مسئولیت هوش مصنوعی به دو جنبه اساسی تمرکز داشت: نقش سازندگان و کاربران. از یک سو، سازندگان به عنوان افراد یا سازمانهایی که سیستمهای هوش مصنوعی را توسعه میدهند، باید مسئولیت اخلاقی و حقوقی را به عهده بگیرند و از اطمینان در عملکرد صحیح و پیش بینی و کنترل عواقب ناخواسته اطمینان حاصل کنند. از سوی دیگر، کاربران نیز مسئولیتی در استفاده از سیستمهای هوش مصنوعی دارند و باید با احتیاط و آگاهی، از آنها بهرهبرداری کنند و تأثیرات منفی محتمل را پیش بینی و کنترل نمایند.

این مقاله نشان میدهد که مفهوم مسئولیت در حوزه هوش مصنوعی، یک موضوع پیچیده و چند بعدی است که نیازمند مشارکت و هماهنگی بین افراد، سازمانها و قوانین است. با توجه به رشد روزافزون استفاده از هوش مصنوعی در صنایع و زندگی روزمره، لازم است تا استانداردها و قوانین مربوط به مسئولیت هوش مصنوعی توسعه و تقویت شوند تا اطمینان از استفاده ایمن و اخلاقی از این فناوری فراهم شود و تأثیرات مثبت آن بر جوامع و محیط زیست تضمین گردد.

منبع

آیا این پست برای شما مفید بود؟

برای امتیازدهی بر روی ستارهها کلیک کنید

امتیاز متوسط 4.6 / 5. تعداد: 25

اولین نفر باشید که امتیاز میدهید

نویسنده

روزبه امیری

دانش آموخته مقطع دکتری دانشگاه علم و صنعت در رشته مهندسی صنایع گرایش برنامهریزی و تحلیل سیستمها با بیش از 20 عنوان مقالات علمی و نشریات بین المللی و همچنین 15 سال سابقه کار در حوزههای مدیریت استراتژیک، تحقیق و توسعه، مدیریت دانش و تحول راهبردی.

امید

11 اردیبهشت , 1403خوبه مطلب جدیدی ارائه کردید